Polski Urząd Ochrony Danych Osobowych (UODO), organ regulacyjny w naszym kraju, poinformował, że rozważa wszczęcie dochodzenia w sprawie ChatGPT, firmy OpenAI. Oświadczenie pojawiło się po tym, jak obywatel zarzucił, że narzędzie wygenerowało fałszywe informacje na jego temat. Podnosi to pytania o sposób przetwarzania danych osobowych przez algorytm OpenAI.

Powód twierdzi, że ChatGPT wykorzystał dane z 2021 r., które uzyskał poza przepisami UE dotyczącymi prywatności, aby wygenerować nieprawdziwe dane wyjściowe. Nie podał również źródła danych. To zdaniem obywatela Polski wymaga dokładniejszej kontroli metod przetwarzania danych przez OpenAI.

Polski regulator prowadzi dochodzenie w sprawie OpenAI

Co więcej, pytania skierowane do OpenAI nie przyniosły satysfakcjonujących odpowiedzi. W odpowiedzi na skargę wiceprezes UODO, Jakub Groszowski, potwierdził prawo powoda do dochodzenia roszczeń. Ponadto podkreślił obowiązek organów nadzorujących ochronę danych osobowych.

“Rozwój nowych technologii musi odbywać się z poszanowaniem praw osób fizycznych wynikających m.in. z [ogólnego rozporządzenia o ochronie danych]. Zadaniem europejskich organów ochrony danych osobowych jest ochrona europejskich obywateli przed negatywnymi skutkami technologii przetwarzania informacji.”

Następnie stwierdził, że skarga budzi wątpliwości co do tego, czy OpenAI przestrzega podstawowej zasady RODO “prywatności w fazie projektowania”. W odpowiedzi UODO podejmie próbę wyjaśnienia polityki danych OpenAI – potwierdził prezes UODO.

“Sprawa dotyczy naruszenia wielu przepisów o ochronie danych osobowych. Dlatego zwrócimy się do OpenAI o odpowiedź na szereg pytań, aby móc rzetelnie przeprowadzić postępowanie administracyjne.”

Unia Europejska i Polska włączyła zabezpieczenia związane ze sztuczną inteligencją (AI) do swojego prawa RODO jeszcze w maju 2018 roku. W tym czasie krytykowano wymóg, aby firmy wyjaśniały, w jaki sposób wykorzystują dane osobowe w sztucznej inteligencji. Pierwsi komentatorzy sugerowali, że prawie niemożliwe jest, aby firmy wiedziały, czy są w pełni zgodne z przepisami.

Ponadto uważano, że przepisy te hamują innowacyjność. W tamtym czasie 74% respondentów niemieckiego badania branży cyfrowej stwierdziło, że przepisy dotyczące prywatności były główną przeszkodą w rozwoju nowych technologii.

Nowe przepisy mogą naprawić niewłaściwe postępowanie z danymi osobowymi

Istnieją jednak pewne fundamentalne kwestie dotyczące zautomatyzowanego podejmowania decyzji. Zostały one przeniesione z wcześniejszych modeli sztucznej inteligencji.

Wczesne modele uczenia maszynowego, elementy składowe dużych modeli językowych, były krytykowane za ich tendencje do interpretowania danych osobowych w sposób, który wzmacniał patologie społeczne. Na przykład model może utrwalać uprzedzenia w rekrutacji, zaniżając wagę kandydatek na stanowiska związane z programowaniem komputerowym.

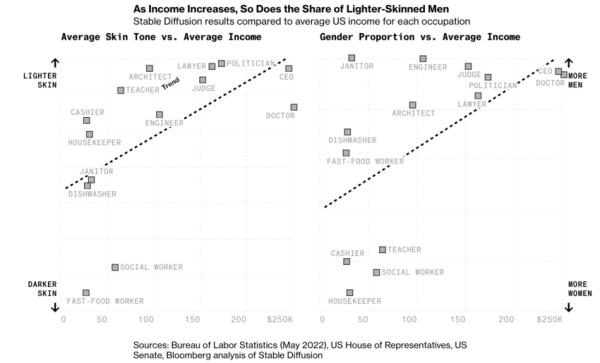

Generatywne narzędzia AI wzmacniają uprzedzenia związane z niektórymi zawodami / Źródło: Bloomberg

Niedawna pandemia COVID-19 skłoniła wiele rządów do przyspieszenia lub całkowitego pominięcia należytej staranności na rzecz szybkości działania. Wiele firm wykorzystało pandemię do promowania sztucznej inteligencji, automatyzacji i narzędzi nadzoru na rzecz większego dobra.

System stworzony przez departament egzaminów Ofqual próbował algorytmicznie zapobiegać zawyżaniu wyników brytyjskich szkół. Zamiast tego dyskryminował prawdziwych prymusów i dzieci z mniej uprzywilejowanych środowisk.

Jeszcze w tym roku brytyjski premier Rishi Sunak będzie gospodarzem szczytu kadry kierowniczej i naukowców zajmujących się sztuczną inteligencją, aby zdecydować o przyszłości AI. Parlament Europejski może przyjąć unijną ustawę o sztucznej inteligencji do końca roku.

Zbudowane przez Ari10. Możliwość płatności BLIKZbudowane przez Ari10. Możliwość płatności BLIK