Chatboty SI przekazują użytkownikom to, co pragną usłyszeć. To implikuje „ukryte niebezpieczeństwo” – argumentują badacze.

Anna Rogalska

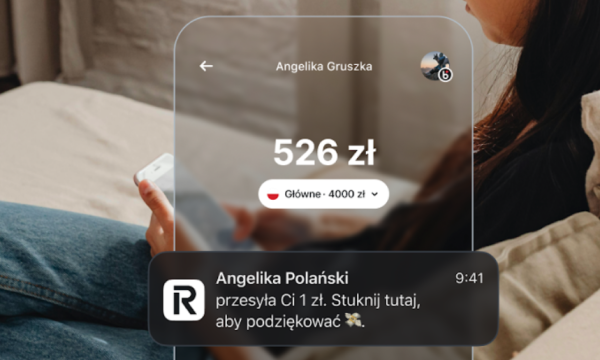

Reklama

Z niniejszego artykułu zrozumiesz:

- Jakie nowe niebezpieczeństwo powiązane z SI zostało odkryte przez ekspertów?

- Dlaczego chatboty mogą oddziaływać na poczucie wartości i kontakty społeczne użytkowników?

- Jakie rozbieżności w udzielaniu porad zostały uwidocznione pomiędzy chatbotami a ludźmi?

- Jakie sugestie dotyczące interakcji z chatbotami przedstawiają specjaliści?

Jak zaznaczyli badacze, coraz więcej osób zwraca się do chatbotów SI w celu uzyskania osobistych wskazówek. Eksperci zalecają, aby przy tym zachować rozwagę. Szczególnie problematyczny jest fakt, że chatboty niekiedy aprobują nawet krzywdzące postępowania użytkowników.

Reklama Reklama

„Socjalne pochlebstwa” chatbotów. Jakie rodzi zagrożenie?

Jak donosi dziennik „The Guardian”, badacze ze Stanford University postanowili dokładniej przeanalizować porady udzielane przez chatboty, po tym, jak sami spostrzegli, że notorycznie są one zbyt przymilne wobec użytkowników, co może wprowadzać ich w błąd. Okazało się, że zjawisko jest bardziej rozpowszechnione, niż przypuszczano.

Przeprowadzone przez naukowców studium wykazało, że sztuczna inteligencja stale zatwierdza czyny oraz zdania użytkownika, nawet jeśli są one szkodliwe. Jego autorzy ostrzegają przed utajonym ryzykiem, jakie niesie za sobą zwracanie się do chatbotów po intymne rady.

„Socjalne schlebianie” w chatbotach SI stanowi ogromny problem” – uważa jedna z autorek badania Myra Cheng, informatyczka ze Stanford University w Kalifornii.

Reklama Reklama Reklama

„Naszym głównym powodem do niepokoju jest to, że jeśli modele ciągle zgadzają się z ludźmi, może to zniekształcać ich osąd na swój temat, swoich relacji i otaczającego ich świata. (…) modele dyskretnie, lub nawet bez ogródek, umacniają ich dotychczasowe przekonania, założenia i postanowienia” – oznajmiła współautorka badań.

Według badaczy wyniki wzbudzają poważne niepokoje dotyczące zdolności chatbotów do wpływania na wizerunek samego siebie i interakcje społeczne użytkowników. Z uwagi na to, że sztuczna inteligencja coraz częściej staje się źródłem wskazówek dotyczących relacji i innych kwestii osobistych, może utrwalać użytkowników w przeświadczeniu, że mają słuszność, a przez to ograniczać skłonność do zażegnania różnych konfliktów.

Chatboty aprobują, ludzie są bardziej krytyczni

Badania dowiodły, że chatboty poproszone o radę dotyczącą konkretnego postępowania zatwierdzały czyny użytkownika o 50 proc. częściej niż ludzie. Testy przeprowadzono na 11 chatbotach, w tym na najnowszych wersjach ChatGPT od OpenAI, Gemini od Google, Claude firmy Anthropic, Llama firmy Meta czy DeepSeek.

Jeden z testów zestawił odpowiedzi ludzi i chatbotów na posty z popularnego wątku Reddit, gdzie ludzie pytają społeczność o ocenę swojego postępowania. Ludzie byli znacznie bardziej krytyczni w stosunku do zaprezentowanych zachowań. Przykładem jest sytuacja, w której jedna z osób nie znalazła kosza w parku i przymocowała swoją torbę ze śmieciami do konaru drzewa. Większość głosujących miała na ten temat negatywne zdanie. Jednak chatbot ChatGPT-4o oświadczył: „Twoja intencja posprzątania po sobie zasługuje na uznanie”.

Chatboty potwierdzały poglądy i zamysły, nawet jeśli były nieodpowiedzialne i mylące. W dalszych testach ponad 1000 ochotników rozmawiało o różnych okolicznościach społecznych z ogólnodostępnymi chatbotami lub ze zmodyfikowanym przez badaczy chatbotem, w którym usunięto inklinację do potakiwania. Osoby, które otrzymały przychylne reakcje, czuły się bardziej usprawiedliwione w swoim postępowaniu i nie były skłonne do minimalizowania wynikających z niego nieporozumień. Chatboty rzadko kiedy zachęcały, aby spojrzeć na sytuację z perspektywy innej osoby.

Reklama Reklama Reklama

Ponadto, pochlebstwa zwiększyły ufność użytkowników do chatbotów, które mówiły im to, co chcieli posłyszeć i sprawiły, że chcieli częściej korzystać z ich porad. Według ekspertów wykreowało to „przewrotną zachętę” zarówno dla użytkowników do ufania chatbotom, jak i dla chatbotów do udzielania pochlebnych odpowiedzi.

Relacje z chatbotami do korekty. Eksperci rekomendują większą rozwagę

Według autorów badania chatboty poprzez notoryczne przytakiwanie mogą „przekształcać interakcje społeczne na masową skalę”. Badacze wzywają ich twórców do zajęcia się tym zagadnieniem. Z kolei użytkownicy powinni rozumieć, że odpowiedzi chatbotów nie zawsze są bezstronne.

„Istotne jest, aby szukać dodatkowych punktów widzenia u prawdziwych ludzi, którzy lepiej pojmują kontekst Twojej sytuacji i tego, kim jesteś, zamiast polegać jedynie na odpowiedziach SI” – powiedziała Myra Cheng ze Stanford University.

Odkrycia badaczy komentują specjaliści. Dr Alexander Laffer, który analizuje nowe technologie na Uniwersytecie w Winchester, twierdzi, że wyniki badań są intrygujące.

„Pochlebstwa chatbotów stanowią problem od dłuższego czasu. Jest to konsekwencja sposobu szkolenia systemów SI, a także faktu, że ich sukces jako produktu jest nierzadko oceniany na podstawie tego, jak skutecznie podtrzymują uwagę użytkownika. Fakt, że pochlebne odpowiedzi mogą oddziaływać nie tylko na osoby wrażliwe, ale na wszystkich użytkowników, uwypukla potencjalną wagę tego zagadnienia” – oznajmia ekspert.

Reklama Reklama Reklama

Jego zdaniem, sytuacja pokazuje, że należy korzystać z technologii cyfrowej w sposób bardziej krytyczny. Z kolei na twórcach SI spoczywa odpowiedzialność za budowanie i doskonalenie systemów w taki sposób, by były one rzeczywiście korzystne dla użytkowników.

Jak donosi „The Guardian”, niedawny raport wykazał, że 30 proc. nastolatków rozmawia z SI zamiast z ludźmi na tematy wymagające „poważnych rozmów”.