Drugi projekt ogólnego Kodeksu postępowania w zakresie sztucznej inteligencji jest zbyt szczegółowy i niejasny, a wady te mogą prowadzić do spowolnienia innowacji, zwłaszcza w przypadku małych i średnich przedsiębiorstw – podała AI Chamber w komunikacie prasowym.

AI Chamber (Izba AI), instytucja zrzeszająca już kilkadziesiąt startupów, firm, organizacji i ngos-ów AI w Polsce, w imieniu reprezentowanych podmiotów przedłożyła w unijnym Biurze ds. Sztucznej Inteligencji oficjalne stanowisko na temat drugiego projektu ogólnego Kodeksu postępowania w zakresie sztucznej inteligencji (Second Draft General Purpose AI Code of Conduct).

Kodeks jest przewodnim dokumentem dla dostawców modeli AI ogólnego przeznaczenia w zakresie wykazywania zgodności z ustawą o AI (AI Act) w całym cyklu życia modeli. Czasu na poprawki jest mało – ostateczny Kodeks powinien być gotowy w kwietniu br., ponieważ przepisy ustawy o AI zaczną obowiązywać już w sierpniu 2025 r.

Izba wskazała na kluczowe błędy w projekcie Komisji Europejskiej, jak m.in.: złożoność i surowość regulacji, trudne do wdrożenia przepisy, kontrowersyjne zasady dotyczące prawa autorskiego, nadmierne wymagania dotyczące ujawniania informacji stanowiące zagrożenie dla bezpieczeństwa publicznego i tajemnic handlowych, czy tworzenie nowych obowiązków dla dostawców modeli AI wykraczających poza to, co przewiduje AI Act.

Wskazano, że złożoność i surowość przepisów może zniechęcać firmy do rozwijania własnych modeli AI, zwłaszcza przez małe i średnie przedsiębiorstwa (MŚP), które mogą uznać koszty i wysiłek związany z przestrzeganiem tych regulacji za zbyt wysokie.

Według Izby, już teraz AI Act i obciążenia, jakie nakłada na rozwój sztucznej inteligencji, stawiają UE w niekorzystnej sytuacji w 'wyścigu sztucznej inteligencji', zwłaszcza względem USA i Chin. Kodeksy postępowania, takie jak GPAI Code of Conduct, powinny ułatwiać zgodność z przepisami AI Act, aby Europa pozostała atrakcyjnym miejscem do tworzenia modeli AI i rozwiązań opartych na tej technologii.

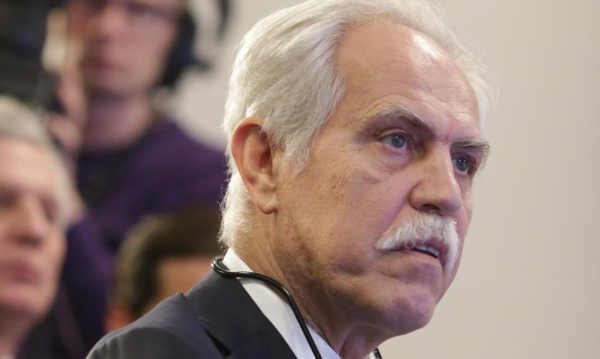

"Zamiast wspierać dynamiczne i konkurencyjne środowisko dla rozwoju AI, UE ryzykuje stworzenie z Kodeksu 'biurokratycznego potwora'. Chociaż w porównaniu z wcześniejszą wersją Kodeksu wprowadzono pewne usprawnienia, dokument w obecnym kształcie nadal nie spełnia swojego podstawowego celu" – powiedział cytowany w komunikacie prasowym Tomasz Snażyk, CEO AI Chamber.

"Z perspektywy europejskich przedsiębiorców wartość dodana Kodeksu jest znikoma, natomiast ciężar jego wdrożenia – zarówno finansowy, jak i administracyjny – może skutecznie zdusić innowacyjny zapał" – dodał.

Podano, że Kodeks zawiera nadmiernie szczegółowe wskaźniki KPI (Key Performance Indicators), które są trudne do wdrożenia i niejednoznaczne. Na przykład wymagania dotyczące dokumentacji są obszerne, ale brakuje jasnego uzasadnienia ich konieczności. Wymaganie szczegółowych informacji o parametrach modeli AI i danych używanych do ich szkolenia może naruszać tajemnice handlowe i prawa własności intelektualnej, a także zagrażać bezpieczeństwu publicznemu i zniechęcać do tworzenia innowacji.

Jak zaznacza AI Chamber, projekt Kodeksu wprowadza obowiązki, które nie są przewidziane w AI Act. Na przykład narzuca zbyt surowe wymagania dotyczące zgodności z prawami autorskimi zbiorów danych stron trzecich. Wymaganie, aby wewnętrzne zasady dotyczące praw autorskich były 'zgodne ze zobowiązaniami Kodeksu', jest problematyczne, ponieważ Kodeks nie powinien ograniczać swobody dostawców w zakresie niezależnej oceny prawa autorskiego UE.

Roszczenie podejmowania przez twórców modeli AI "rozsądnych działań" w celu oceny zgodności z prawami autorskimi zbiorów danych stron trzecich wykracza poza zakres prawa UE.

Ponadto, jak podkreśla Izba, obowiązek stosowania polityk na każdym etapie rozwoju modelu jest zbyt szeroki i trudny do zrealizowania, a postulat monitorowania praw innych podmiotów jest niepraktyczny i ingeruje w umowy handlowe. Co więcej, wprowadzenie w Kodeksie dodatkowych przepisów o charakterze eksterytorialnym budzi poważne wątpliwości prawne.

Zdaniem Izby, rozmiar modelu AI lub wysokość mocy niezbędnej do jego trenowania nie są dobrymi wskaźnikami do oceny rzeczywistego ryzyka, jakie stwarzają nowe technologie. Podczas gdy generalnie Izba popiera zwolnienie MŚP z przepisów nakazowych, ponieważ brakuje im zasobów do pełnego przestrzegania Kodeksu, czasami takie podejście może stworzyć lukę prawną, w której modele AI oferowane przez małe i średnie firmy mogłyby mieć niższe standardy bezpieczeństwa i stwarzać znaczne ryzyko nadużyć określonych w AI Act.

"Duża część wytycznych pozostaje nadmiernie uciążliwa i normatywna, nakładając dodatkowe obowiązki na dostawców systemów sztucznej inteligencji. To sprawia, że dokument jest niefunkcjonalny. Nowo powstające firmy AI, które stoją przed decyzją, czy opracować własny model – w obliczu tak skomplikowanych zasad Kodeksu, mogą po prostu stwierdzić, że nie warto podejmować tego wysiłku, tracąc korzyści płynące z AI" – powiedział Tomasz Snażyk. (PAP Biznes)

alk/ ana/