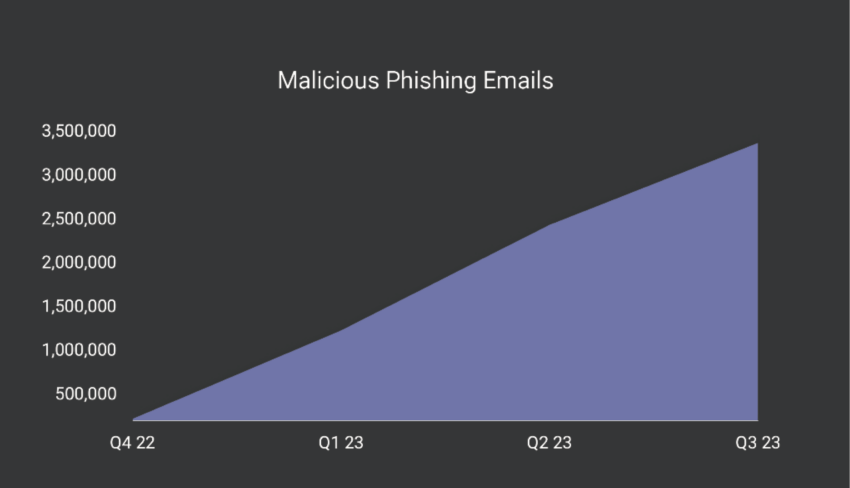

Popularyzacja sztucznej inteligencji poważnie wpływa na różne sfery życia i działalności. Niestety, każda innowacja ma swoje minusy: sztuczna inteligencja stała się również narzędziem, które znacznie ułatwia życie oszustom. Według analityków liczba wiadomości phishingowych wzrosła o około 1265 procent od czasu wydania ChatGPT. Oszuści aktywnie badają możliwości nowej technologii i wykorzystują je do osiągania nieetycznych celów.

Na początku tego miesiąca szef firmy-twórcy ChatGPT – OpenAI, Sam Altman, skomentował temat kryptowalut. Przedsiębiorca nazwał Bitcoina najlepszym narzędziem do walki z korupcją, ponieważ zjawisko to rzekomo zniknie, gdy aktywa cyfrowe oparte na przejrzystych blockchainach staną się bardziej popularne. Przeczytaj więcej o punkcie widzenia Altmana w osobnym materiale.

Jak oszuści kradną kryptowaluty?

Zestaw funkcji ChatGPT jest w pełni wykorzystywany przez cyberprzestępców. Stworzyli oni już własne wersje chatbota, skoncentrowane wyłącznie na oszustwach. Mowa o oprogramowaniu WormGPT, Dark Bart i FraudGPT, które aktywnie krąży w darknecie i szuka nabywców do dalszej “pracy”.

W rozmowie z dziennikarzami Decrypt, CEO SlashNext Patrick Harr skomentował główne źródło problemu. Oto jego zdanie:

“Kiedy ChatGPT został wydany w lutym, zaobserwowaliśmy dramatyczny wzrost ataków phishingowych. Oczywiście było to częściowo spowodowane wzrostem ich skuteczności.”

Ataki phishingowe

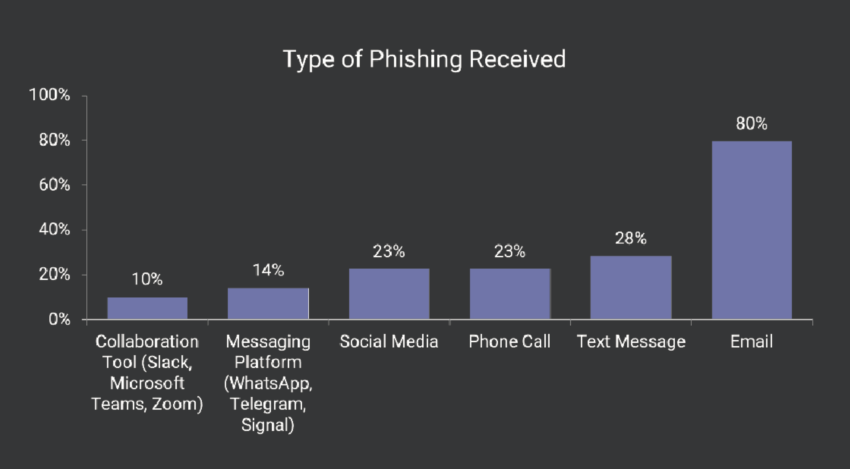

Podsumowując, atak phishingowy to komunikacja między oszustem a ofiarą, w której ten pierwszy imituje wiadomości z zaufanego źródła. Może to być banalny spam, osobiste wiadomości w sieciach społecznościowych lub po prostu tekst na złośliwej stronie internetowej.

Ofiara jest proszona o kliknięcie w link pod jakimś ważnym pretekstem, po czym jest zapraszana do wprowadzenia kluczowych informacji na swój temat – danych osobowych, haseł i itd.

Oczywiście i tutaj można wykorzystać możliwości sztucznej inteligencji. Przykładowo, bot jest w stanie pomóc w skomponowaniu tekstu, który nie będzie budził wątpliwości native speakerów. To samo można wykorzystać w korespondencji z potencjalną ofiarą.

Jak okazało się we wrześniu, ChatGPT jest również w stanie pomóc w uruchomieniu własnej kryptowaluty, która w tym przypadku okazała się tokenem memowym o nazwie AstroPepeX (APX). Chociaż ten przypadek wymagał dodatkowych umiejętności programistycznych, przykład i tak był więcej niż udany.

Oszuści polują głównie na Twitterze

Oszustów jest szczególnie dużo na Twitterze. Według analityków SlashNext, często podszywają się oni pod celebrytów i “rozdają” kryptowaluty.

Schemat jest prosty: oszuści zmieniają nazwę onta na Twitterze, udając konto celebryty. Platforma jest następnie wykorzystywana do promowania publikacji reklamującej “rozdawanie monet”. Aby otrzymać kryptowalutę, ofiary są proszone o wysłanie niewielkiej ilości kryptowalut do określonego portfela – rzekomo w celu potwierdzenia własnego adresu. W zamian obiecuje się podwojenie pieniędzy, choć w rzeczywistości zostają one w rękach hakerów.

W bieżącym czwartym kwartale 2023 r. oszuści przeprowadzają średnio 31 000 ataków phishingowych dziennie – co stanowi wzrost o 967 procent w porównaniu z tym samym okresem ubiegłego roku. 68 procent ataków to spam w imieniu firm, podczas gdy 39 procent to spam SMS na urządzenia mobilne.

Harr powiedział, że pojawienie się ChatGPT znacznie ułatwiło oszustom wykonywanie rutynowych zadań.

“Pomimo pewnej debaty na temat rzeczywistego wpływu sztucznej inteligencji na działania cyberprzestępców, dzięki naszym badaniom wiemy o korzystaniu przez nich z narzędzi takich jak ChatGPT. Używają go do generowania ogromnej ilości tekstów phishingowych.”‘

Jakie jest rozwiązanie?

Musimy teraz przeciwdziałać temu negatywnemu trendowi, a Harr ma rozwiązanie. Sugeruje wykorzystanie tej samej sztucznej inteligencji do walki ze zwiększoną aktywnością oszustów.

Firmy zajmujące się cyberbezpieczeństwem powinny włączyć sztuczną inteligencję bezpośrednio do swoich programów przeciwdziałania oszustwom. Sztuczna inteligencja powinna stale przyglądać się wszystkim kanałom komunikacji i eliminować zagrożenia. Właśnie dlatego używamy generatywnej sztucznej inteligencji w naszych własnych zestawach narzędzi do wykrywania, a także blokowania, a nawet przewidywania, jak rozegra się następny atak.”

ChatGPT nie może, w przypadku wielu zapytań tekstowych, być wykorzystywany do takich celów, podobnie jak żadna inna sztuczna inteligencja. W tym celu należy opracować nowe AI. Zadanie to wymaga ogromnych zasobów i czasu.

Faktem jest, że nawet firma OpenAI ze swoimi ogromnymi możliwościami nie była w stanie zapobiec wykorzystywaniu swoich modeli sztucznej inteligencji do niecnych celów. Opracowanie czegoś, co mogłoby przeciwdziałać hakerom w sieci, jest nietrywialnym zadaniem, które wymaga dużych inwestycji.

Zbudowane przez Ari10. Możliwość płatności BLIKZbudowane przez Ari10. Możliwość płatności BLIK